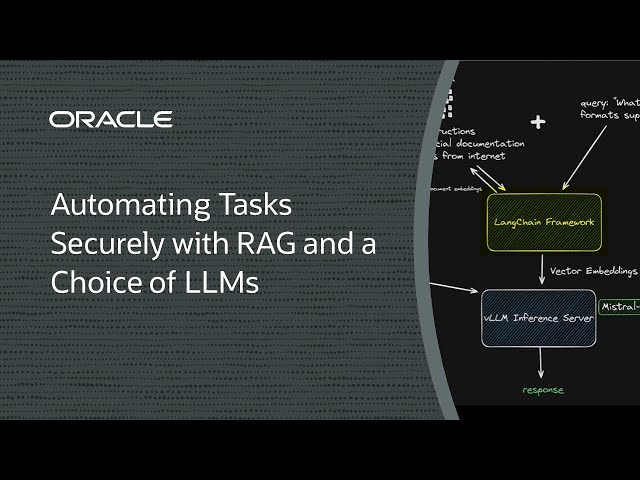

Automatizzare le attività in modo sicuro con RAG e una scelta di LLM

Introduzione

Nel tentativo di semplificare le attività ripetitive o automatizzarle completamente, perché non avvalersi dell'aiuto dell'AI? L'utilizzo di un modello di base per automatizzare le attività ripetitive può sembrare allettante, ma può mettere a rischio dati riservati. La Retrieval-augmented generation (RAG) è un'alternativa all'ottimizzazione, mantenendo i dati di inferenza isolati dal corpus di un modello.

Vogliamo mantenere separati i nostri dati di inferenza e il nostro modello, ma vogliamo anche scegliere in quale modello linguistico di grandi dimensioni (LLM, large language model) utilizziamo e una GPU potente per garantire l'efficienza. Immagina se potessi fare tutto questo con una sola GPU!

In questa demo, mostreremo come distribuire una soluzione RAG utilizzando una singola GPU NVIDIA A10, un framework open source come LangChain, LlamaIndex, Qdrant o vLLM e un LLM leggero da 7 miliardi di parametri di Mistral AI. Si tratta di un ottimo equilibrio tra prezzo e prestazioni e mantiene separati i dati di inferenza durante l'aggiornamento dei dati in base alle esigenze.

Demo

Prerequisiti e impostazione

- Account Oracle Cloud: pagina di iscrizione

- Istanza di computazione GPU Oracle: documentazione

- LlamaIndex—documentazione

- LangChain—documentazione

- vLLM - documentazione

- Qdrant: documentazione